本地部署DeepSeek

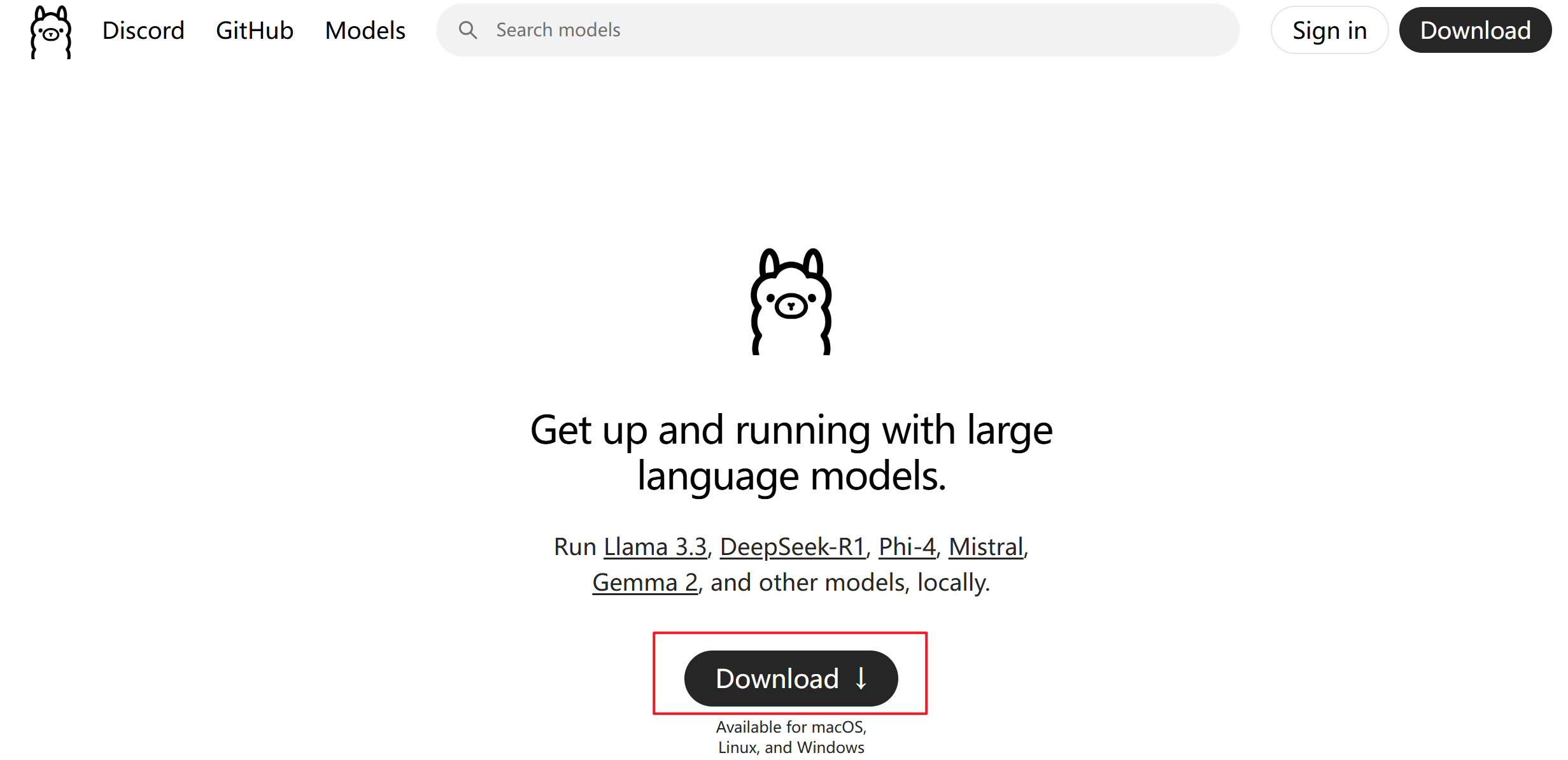

1. 安装OLLAMA

Ollama 是一个本地模型运行工具,可以方便地下载和运行各种开源模型,正好适合我们的DeepSeek 。

下载地址:https://ollama.com/

根据你电脑的操作系统选择下载的Ollama版本,并进行安装。

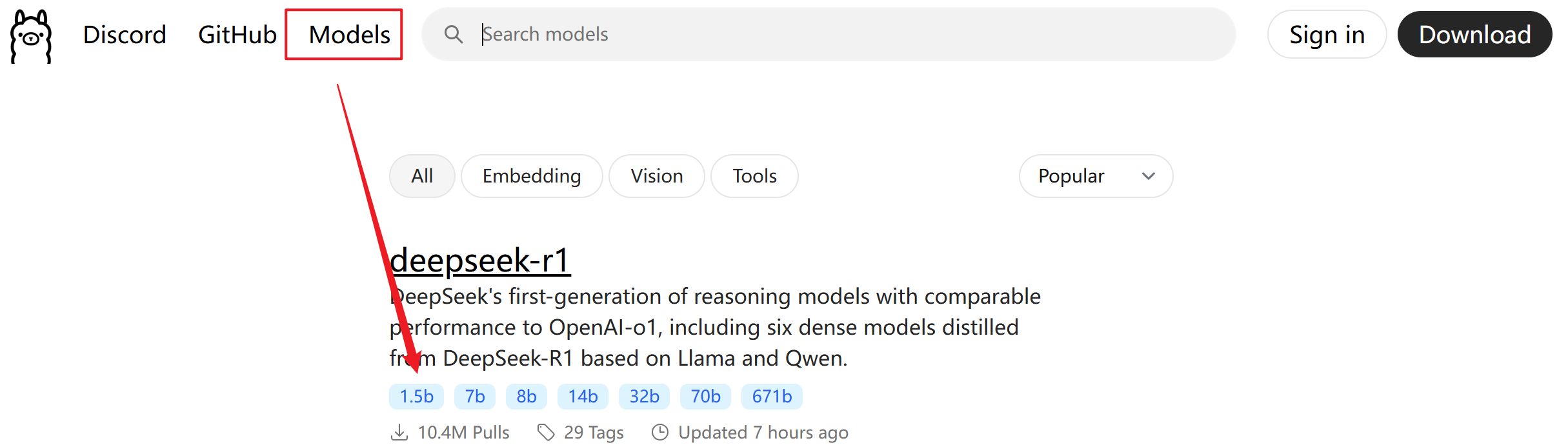

2. 下载并运行DeepSeek模型

先查看Ollama支持的模型列表,地址:https://ollama.com/search

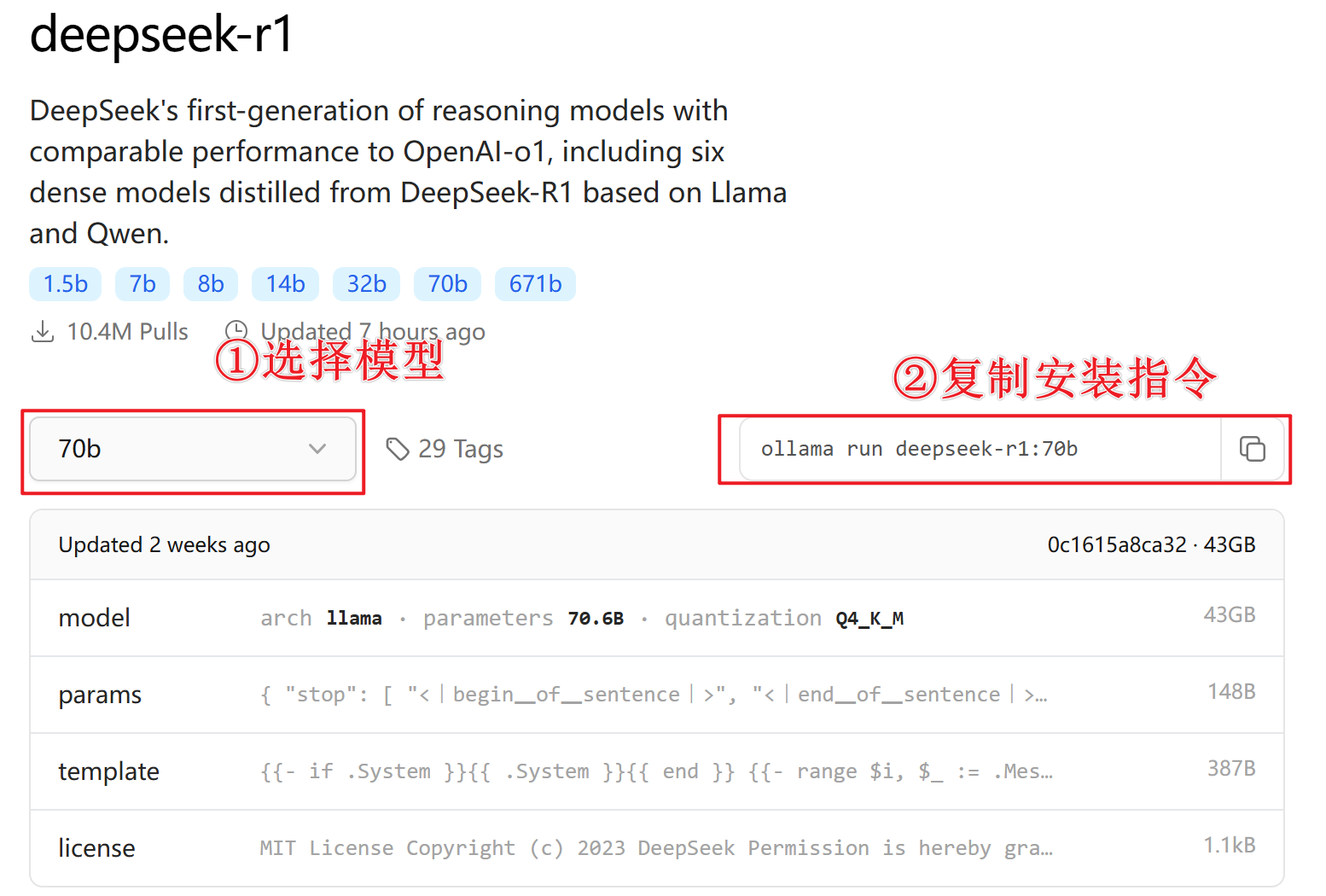

选择deepseek-r1模型。deepseek-r1模型有1.5b 7b 32b 671b等版本,数字越大的,模型性能越好,占用内存也越大,选择你电脑带得动的版本。

复制指令后在本地的命令窗口执行进行安装对应的deepseek模型。

看到这个界面,恭喜你,说明你的deepseek安装成功了!

3. 测试DeepSeek模型

deepseek安装成功了,咱们来测试一下,抛出这两天一直盘旋在我脑中的一个问题:

“开工大吉了,可我还不想上班怎么办?”

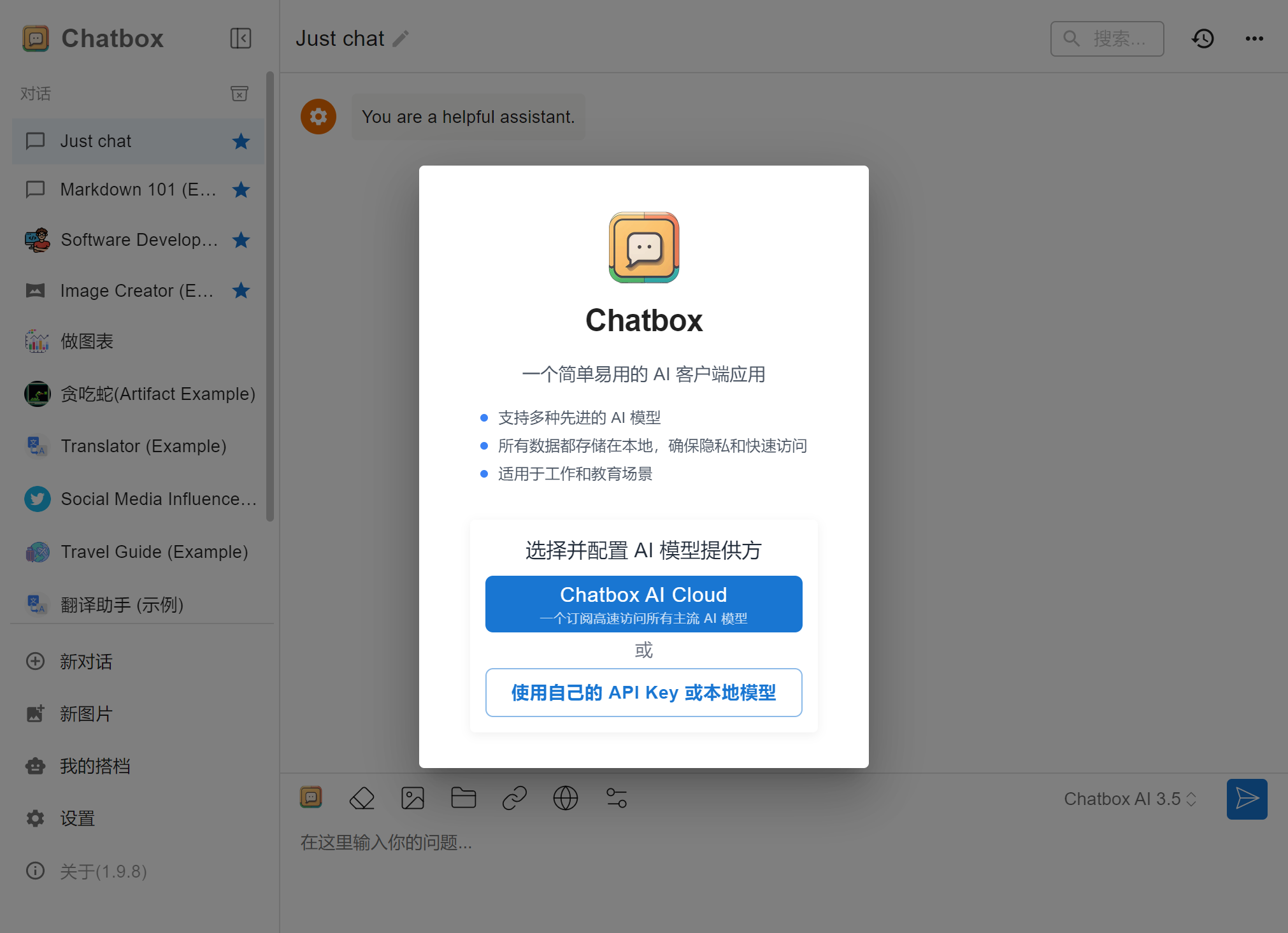

4. 安装Chatbox

虽然我们已经成功在本地安装部署deepseek了,但是每次通过终端去访问毕竟不方便。

这里推荐安装一个工具Chatbox。

官方的介绍:Chatbox 可以很好地连接到 Ollama 服务,让你在使用本地模型时可以获取 Chatbox 提供的更多强大功能,比如 Artifact Preview、文件解析、会话话题管理、Prompt 管理等。

chatbox网址:https://chatboxai.app/zh

可以选择【免费下载】客户端,也可以直接【启动网页版】。

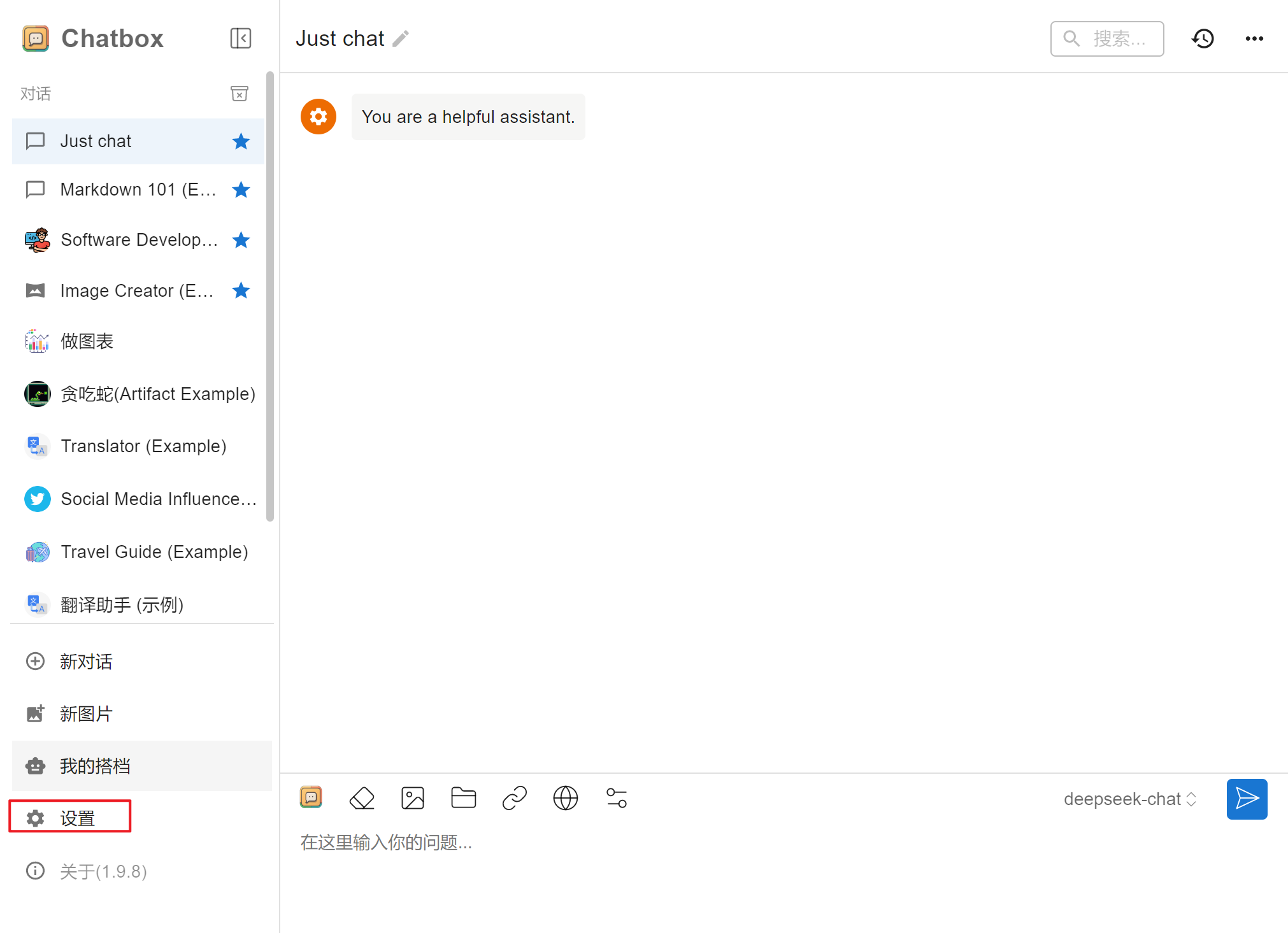

我这里选择了下载客户端,安装后进行简单的配置。

在跳出的弹窗中选择【使用自己的API Key 或本地模型】,也可以在主界面点击【设置】

选择模型提供方-Ollama API

选择我们安装过的deepseek模型

点击保存,可以在聊天窗口中,看到我们当前使用的大模型

提问试试能否正常使用:

哦了,到这里我们的deepseek本地化部署就轻松地完成了!